Настройка Openclaw (Clawdbot/Moltbot)

Полное пошаговое руководство по установке Openclaw: от локальной настройки с Ollama до развертывания в Docker.

В этом руководстве мы разберем два основных способа запуска вашего персонального ИИ-ассистента Openclaw (ранее известного как Clawdbot или Moltbot): классическую установку с локальной моделью и развертывание в Docker для максимальной изоляции.

Вариант 1: Установка через Ollama (Gemini 3 Flash)

Этот метод рекомендуется, если вы хотите использовать возможности мощной модели Gemini 3 Flash Preview. Важно понимать: эта модель работает через Ollama Cloud, а ваш локальный клиент Ollama выступает в роли моста (интерфейса). Это позволяет использовать современные ИИ-возможности без мощного GPU на своей стороне.

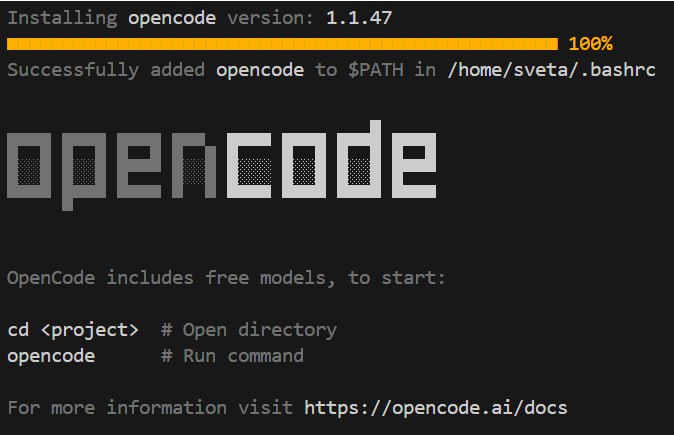

1. Подготовка OpenCode CLI

Устанавливаем вспомогательный инструмент для работы с кодом и окружением. OpenCode — это ваш ИИ-терминал. Вместо того чтобы запоминать сложные ключи команд Ubuntu, вы можете просто писать: opencode run "ваше пожелание", и он предложит нужную последовательность действий.

curl -fsSL https://opencode.ai/install | bash

source ~/.bashrc

2. Установка и запуск Ollama

Ollama позволяет запускать мощные модели локально. Установим её и загрузим Gemini:

# Установка Ollama

curl -fsSL https://ollama.com/install.sh | sh

# Авторизация (необходима для доступа к моделям Ollama Cloud, таким как Gemini 3 Flash)

ollama signing

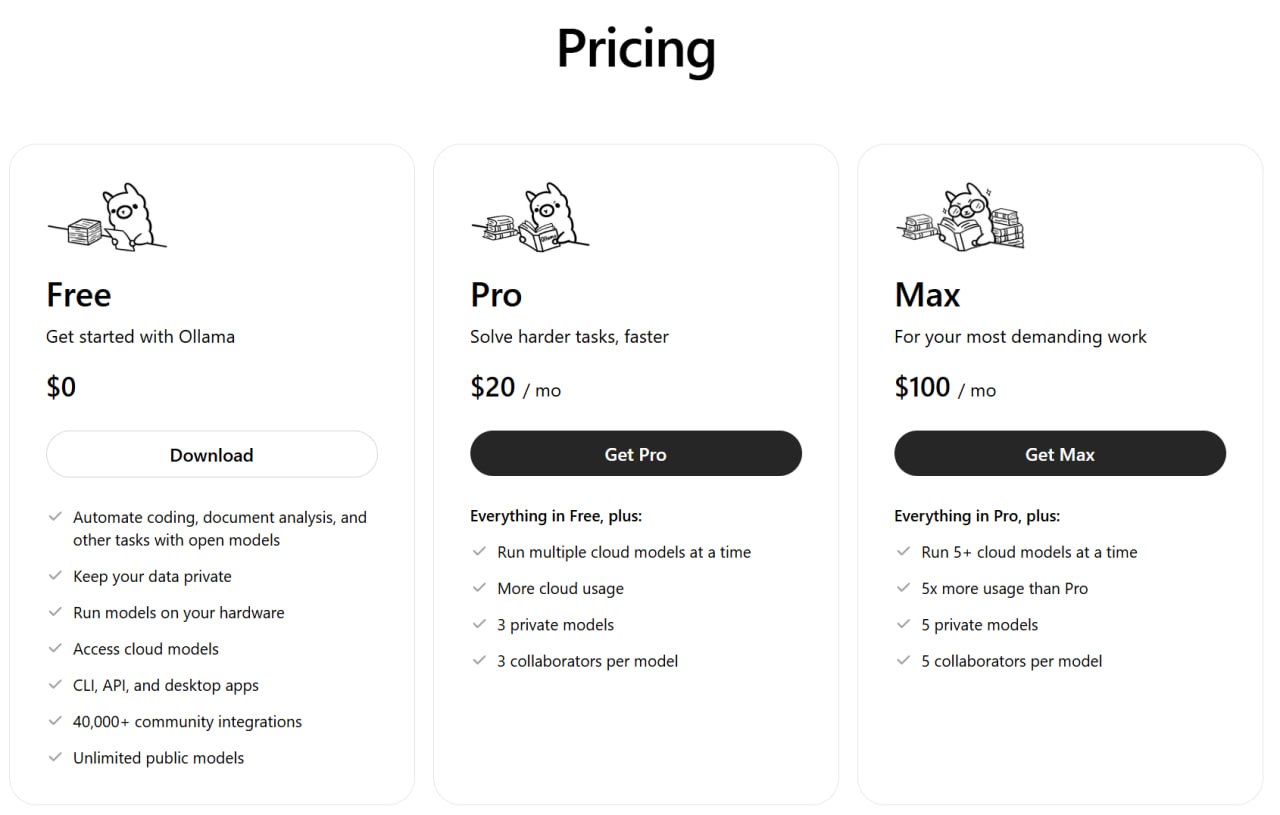

2.1 Подписка Ollama Pro

Для стабильной работы с облачными моделями (такими как Gemini 3 Flash) через Openclaw, рекомендуется оформить подписку Ollama Pro ($20/мес).

Зачем это нужно: Обычные лимиты бесплатного уровня быстро заканчиваются при активной работе ассистента. Подписка Pro фактически «бездонная» — при использовании Gemini 3 Flash через Openclaw вычерпать лимиты за неделю активных тестов нам ни разу не удалось.

3. Загрузка и проверка модели

Загрузим Gemini и проверим, что всё работает:

# Загрузка и проверка модели

ollama run gemini-3-flash-preview

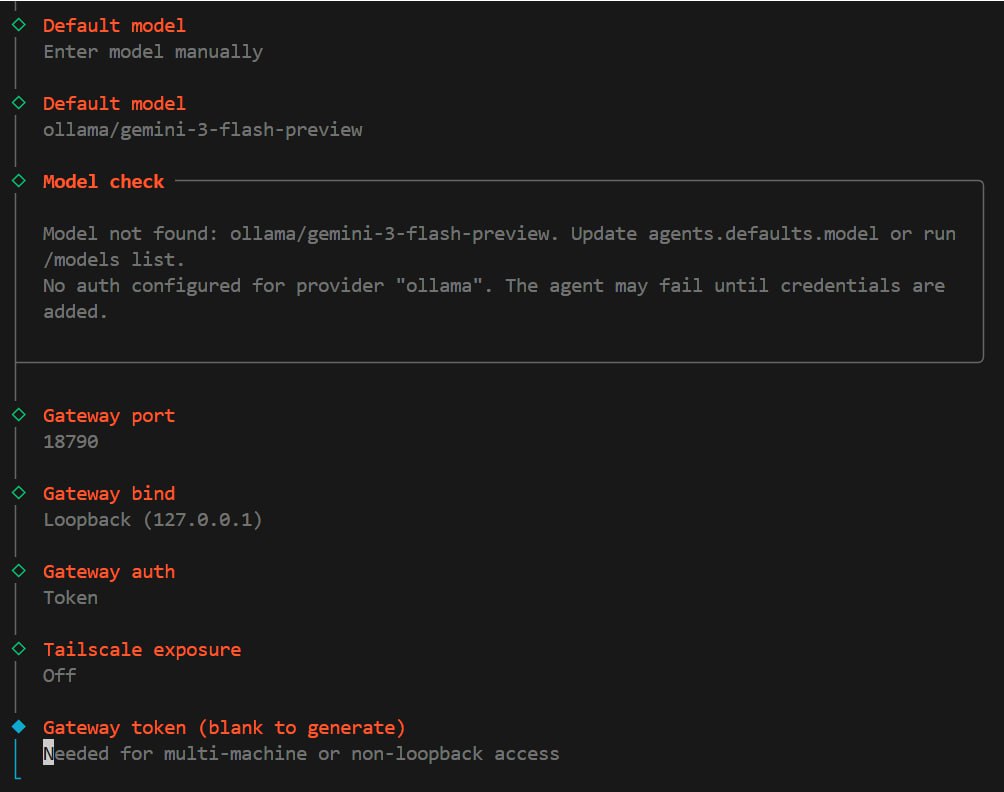

4. Установка Openclaw и онбординг

Устанавливаем ассистента глобально и запускаем мастер настройки:

npm install -g openclaw

openclaw onboard --install-daemon

Важно: На этапе выбора модели в мастере настройки (wizard) пока ничего не выбирайте — мы настроим локальную связку вручную на следующем шаге.

5. Интеграция с Ollama Cloud

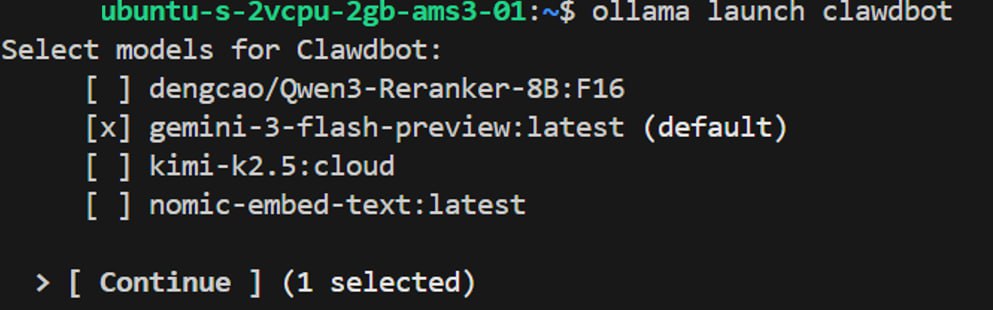

На текущий момент команда прямой интеграции ollama launch clawdbot проходит стадию отладки (issue #4692), поэтому используем проверенный ручной метод для подключения Gemini 3.

- Попробуйте выполнить (для инициализации структуры):

ollama launch clawdbot. - Зайдите в промежуточный конфиг

~/.clawdbot/clawdbot.json. - Скопируйте блок настроек модели и перенесите в основной конфиг

~/.openclaw/openclaw.json.

Ваш итоговый файл в ~/.openclaw/openclaw.json должен содержать эти поля:

{

"agents": {

"defaults": {

"model": { "primary": "ollama/gemini-3-flash-preview:latest" }

}

},

"models": {

"providers": {

"ollama": {

"api": "openai-completions",

"apiKey": "ollama-local",

"baseUrl": "http://127.0.0.1:11434/v1",

"models": [{

"id": "gemini-3-flash-preview:latest",

"name": "gemini-3-flash-preview:latest",

"contextWindow": 131072,

"maxTokens": 16384,

"input": ["text"],

"reasoning": false,

"cost": { "input": 0, "output": 0, "cacheRead": 0, "cacheWrite": 0 }

}]

}

}

}

}

После правки выполните: openclaw gateway restart.

Вариант 2: Установка через Docker

Развертывание в Docker идеально подходит для VPS или если вы хотите изолировать ассистента от основной системы.

1. Быстрый запуск (Docker Compose)

Клонируйте репозиторий и запустите скрипт автоматической подготовки контейнеров:

git clone https://github.com/openclaw/openclaw.git

cd openclaw

./docker-setup.sh

Этот скрипт сделает всё за вас:

- Соберет образ Gateway.

- Запустит интерактивный онбординг внутри контейнера.

- Сгенерирует токен доступа и запишет его в

.env. - Поднимет всю инфраструктуру через Docker Compose.

2. Доступ к панели управления

После завершения работы скрипта откройте в браузере:

http://127.0.0.1:18789 (или IP вашего сервера).

Используйте сгенерированный токен для входа. Все данные ассистента будут надежно храниться на хосте в папке ~/.openclaw/.

3. Ручное управление (если нужно)

Если вы хотите управлять процессом вручную:

# Сборка образа

docker build -t openclaw:local .

# Запуск онбординга

docker compose run --rm openclaw-cli onboard

# Запуск шлюза (Gateway)

docker compose up -d openclaw-gateway

4. Подключение каналов связи в Docker

Для настройки мессенджеров (например, Telegram) используйте командную строку контейнера:

docker compose run --rm openclaw-cli channels add --channel telegram --token "ВАШ_ТОКЕН"

Полезные команды после установки

openclaw status— проверка состояния шлюза.openclaw health— проверка здоровья всех подключенных модулей.openclaw update— обновление до последней версии.

Ваш ИИ-сотрудник готов к работе 24/7!